Possibile che ci siano altri problemi vista l'età dell'hardware.

a rischio di lapidazione, stavolta non sono d'accordo

però è un'impressione che, ho basata su un fattore che pensavo di aver riportato nel post ed invece ho involontariamente taciuto.

Secondo me ad innescare il problema è il surriscaldamento del disco/dischi: dai dati smart, entrambi i dischi non hanno MAI, e sottolineo MAI, evidenziato una temperatura diversa da 40°... nè appena accesi, nè dopo 10 ore, nè dopo intensa attività. MAI, sempre 40°... per dirvi, il grafico in dashboard è completamente piatto.

Sia chiaro, visto che con il disco di boot (stessa marca) avevo avuto problemi a posizionarlo negli slot appositi del case dato che raggiungeva velocemente i 50°, ho posizionato tutti e 3 i dischi in fondo al case proprio di fronte alla ventola (anzi, le 2 ventole) in immissione, con una staffa homemade... hanno praticamente un flusso d'aria costante e diretto, ma nonostante ciò il disco di boot ieri (prima del disastro) ha cominciato a salire di nuovo di temperatura. E questo non me lo posso spiegare se non che il loro "astuccio" non sia adeguato e non riesca a dissipare il calore che sviluppano i chip.

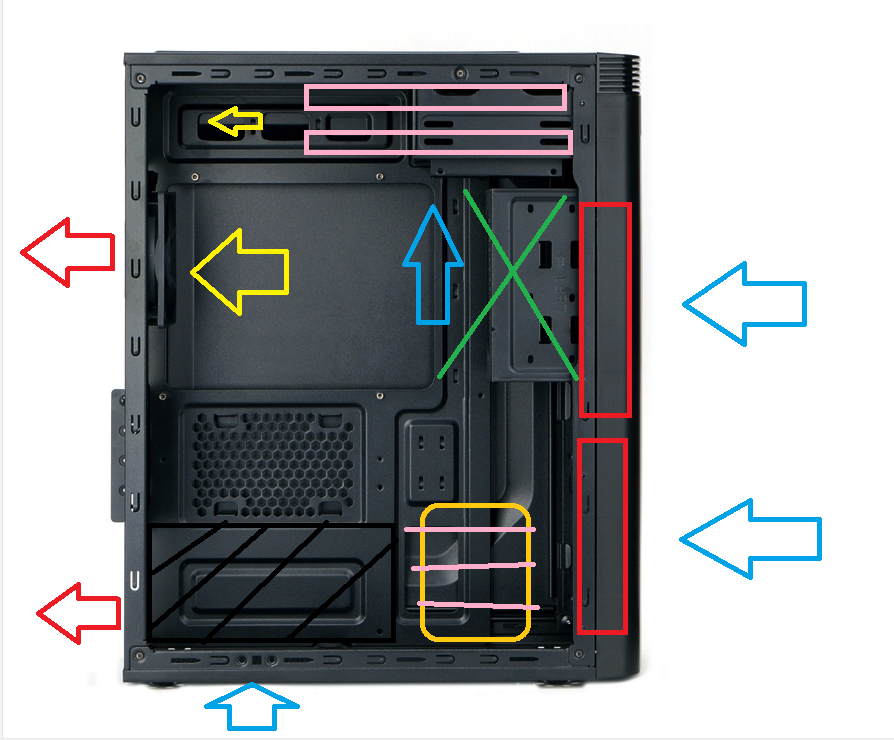

Il ricambio d'aria è abbondante e secondo me non ho commesso errori, piccolo art attack per farvi capire come ho modificato il tutto:

l'aria in entrata è sicuramente leggermente maggiore di quella in uscita (le 2 ventole frontali girano collegate alla CPU, quindi girano quasi sempre a 800rpm massimo 1300) ma la ventola in espulsione, anche se più piccola, gira più velocemente (1500rpm) e smuove abbastanza aria da creare comunque flusso per la parte superiore (dove avevo spostato i dischi, e dove monterò gli altri); inoltre il case è anche forato lateralmente.

Quei due SSD costavano poco perchè valgono meno, me ne disfo asap e capitolo chiuso.

In ogni caso, per essere sicuro al 100%, visto che ho un WD Blue montato nella workstation (che praticamente non uso), prima di darli via lo userò per un po' al posto di quei due dischi (ameno la parità, per ora) per farci le stesse operazioni, e se tutto fila liscio saprò come muovermi...

Se anche così avrò gli stessi problemi, questo pc diventerà il nuovo pc per mia madre xD e metto mano al portafoglio per un sistema meno datato