Etrange en effet...

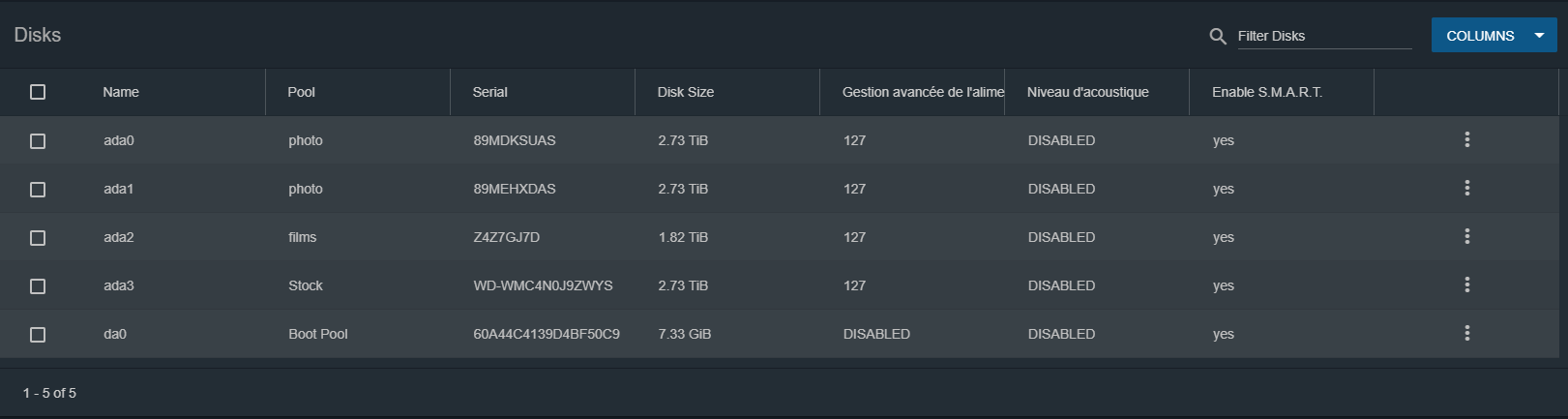

Et c'est plutôt pas mal foutu dans l'interface web, on voit bien que ada0 et ada1 font partie du volume "photot" et que ce dernier est bien constitué de ada0 et ada1. C'est là que je ne m'explique pas.

Pour avoir d'autres pistes, je posterai un message dans la partie anglophone, car il s'agit peut-être d'un bug de FreeNAS mais ça je ne sais pas (j'utilise une version 9.10.x et je ne suis pas très familier avec 11.x). Peut-être que de passer à la version 11.3 permet de corriger cela, je ne sais pas...

La mise à niveau des volumes n'est pas obligatoire.

Une fois qu'on met à niveau un volume, il n'est plus compatible avec une version antérieur de FreeNAS c'est le gros inconvénient.

Donc à moins que le volume soit d'une version qui date d'il y a longtemps (je dirai antérieur à 9.x?) je ne pense pas que cela empêche l'extension automatique. En y repensant, cela peut être une possibilité à ne pas négliger...

Pour vérifier que l'extension de volume est bien possible, la fonctionalité doit être disponible pour ce volume.

Dans un terminal, il faut exécuter les commandes suivantes pour avoir les infos sur la version du volume:

zpool get version <nom_volume> dans le cas présent

zpool get version photo

Dans mon cas j'obtiens ce résultat:

Code:

# zpool get version Poule

NAME PROPERTY VALUE SOURCE

Poule version - default

La version est "-" dans ce cas, on peut vérifier les "feature flags" avec:

zpool get all <nom_volume> | grep feature@

Dans mon cas j'obtiens ce résultat:

Code:

# zpool get all Poule | grep feature@

Poule feature@async_destroy enabled local

Poule feature@empty_bpobj active local

Poule feature@lz4_compress active local

Poule feature@multi_vdev_crash_dump enabled local

Poule feature@spacemap_histogram active local

Poule feature@enabled_txg active local

Poule feature@hole_birth active local

Poule feature@extensible_dataset enabled local

Poule feature@embedded_data active local

Poule feature@bookmarks enabled local

Poule feature@filesystem_limits enabled local

Poule feature@large_blocks enabled local

Poule feature@sha512 enabled local

Poule feature@skein enabled local

Poule feature@device_removal enabled local

Poule feature@obsolete_counts enabled local

Poule feature@zpool_checkpoint enabled local

Poule feature@spacemap_v2 active local

La ligne qui nous intéresse est la ligne

feature@extensible_dataset

Un autre moyen d'obtenir les information sur l'extension est la commande

zpool upgrade -v qui affiche une longue liste.

Exemple dans mon cas:

Code:

# zpool upgrade -v

This system supports ZFS pool feature flags.

The following features are supported:

FEAT DESCRIPTION

-------------------------------------------------------------

async_destroy (read-only compatible)

Destroy filesystems asynchronously.

empty_bpobj (read-only compatible)

Snapshots use less space.

lz4_compress

LZ4 compression algorithm support.

multi_vdev_crash_dump

Crash dumps to multiple vdev pools.

spacemap_histogram (read-only compatible)

Spacemaps maintain space histograms.

enabled_txg (read-only compatible)

Record txg at which a feature is enabled

hole_birth

Retain hole birth txg for more precise zfs send

extensible_dataset

Enhanced dataset functionality, used by other features.

embedded_data

Blocks which compress very well use even less space.

bookmarks (read-only compatible)

"zfs bookmark" command

filesystem_limits (read-only compatible)

Filesystem and snapshot limits.

large_blocks

Support for blocks larger than 128KB.

sha512

SHA-512/256 hash algorithm.

skein

Skein hash algorithm.

device_removal

Top-level vdevs can be removed, reducing logical pool size.

obsolete_counts (read-only compatible)

Reduce memory used by removed devices when their blocks are freed or remapped.

zpool_checkpoint (read-only compatible)

Pool state can be checkpointed, allowing rewind later.

spacemap_v2 (read-only compatible)

Space maps representing large segments are more efficient.

The following legacy versions are also supported:

VER DESCRIPTION

--- --------------------------------------------------------

1 Initial ZFS version

2 Ditto blocks (replicated metadata)

3 Hot spares and double parity RAID-Z

4 zpool history

5 Compression using the gzip algorithm

6 bootfs pool property

7 Separate intent log devices

8 Delegated administration

9 refquota and refreservation properties

10 Cache devices

11 Improved scrub performance

12 Snapshot properties

13 snapused property

14 passthrough-x aclinherit

15 user/group space accounting

16 stmf property support

17 Triple-parity RAID-Z

18 Snapshot user holds

19 Log device removal

20 Compression using zle (zero-length encoding)

21 Deduplication

22 Received properties

23 Slim ZIL

24 System attributes

25 Improved scrub stats

26 Improved snapshot deletion performance

27 Improved snapshot creation performance

28 Multiple vdev replacements

For more information on a particular version, including supported releases,

see the ZFS Administration Guide.

En début de liste on voit que la fonctionalité d'extension est disponible:

Code:

extensible_dataset

Enhanced dataset functionality, used by other features.

Voilà donc deux manières de vérifier que la fonctionalité d'extension est bien disponible pour le volume.