profwalken

Patron

- Joined

- Nov 19, 2013

- Messages

- 410

Bonjour,

j'aimerai un conseil sur le moyen le plus simple de faire un backup quotidien complet sur un TN13 .

Le serveur est configuré avec 2 pools en mirroir, l'un pour le fonctionnement , l'autre pour le backup (je précise que les 2 pools sont de même capacité)

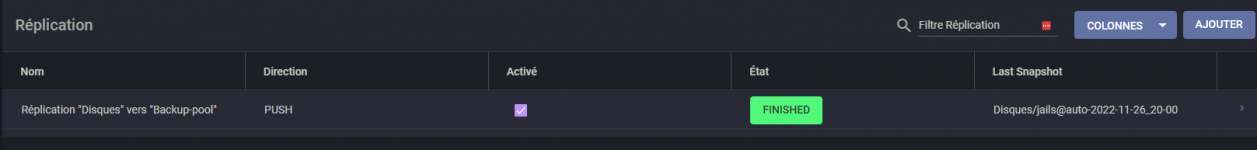

Donc, ce que je souhaite faire c'est un backup complet quotidien du pool A vers le Pool B . J'ai testé en créant une tache de réplication locale entre Pool A et Pool B mais cela ne dure à peine que quelques secondes ce qui me laisse penser que cela ne doit pas faire grand chose.

Tout avis est le bienvenu.

j'aimerai un conseil sur le moyen le plus simple de faire un backup quotidien complet sur un TN13 .

Le serveur est configuré avec 2 pools en mirroir, l'un pour le fonctionnement , l'autre pour le backup (je précise que les 2 pools sont de même capacité)

Donc, ce que je souhaite faire c'est un backup complet quotidien du pool A vers le Pool B . J'ai testé en créant une tache de réplication locale entre Pool A et Pool B mais cela ne dure à peine que quelques secondes ce qui me laisse penser que cela ne doit pas faire grand chose.

Tout avis est le bienvenu.