Bonjour

Cela fait un certain temps que je me pose la question des performances sur le stockage suivant car il ne me semble pas avoir les performances en lien avec la configuration.

Super micro + expandeur sas 24 baie

LSI 9211-8i

CPU E3-1230 v3 @ 3.30GHz

32GB

12 x SSD 850 EVO 1To (11 * RaidZ2 + 1 spare)

2 cartes bi port 10Gbits sur 2 switch 10Gbits Dlink

MTU 9000

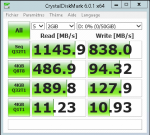

Ci-joint les performances moyenne que j obtiens entre freenas et ESXi en ISCSI en multipathing (cristaldiskmark avec 981.5 mbits)

Ci-joint les performances moyenne que j obtiens entre freenas et ESXI en ISCSI en multipathing en modifiant la talle des blocks (cristaldiskmark avec 6 copie d ecran)

Ci-joint les performances moyenne que j obtiens entre freenas et Windows en ISCSI SANS multipathing (cristaldiskmark avec 1145.9 mbits)

La config est standard

La LSI n'a pas de cache et est configuré avec le bios pour du stockage software

Le freenas est installé sur un raid1 par la carte interne raid et sur 2 SSD separés

Voici la liste des tests realisés

En local sur le freenas (en production)

dd if=/dev/zero of=test2.dat bs=4k count=2000000 => 817 555 495 bytes/sec

dd if=test2.dat of=test1.dat bs=4k count=2000000 => 110 048 055 bytes/sec (Problème de réglage on est plus a 400mbit en general)

dd if=test2.dat of=/dev/null bs=4k count=2000000 => 130 687 897 bytes/sec (idem probleme de reglage on est sense est plus haut)

La suppression des log -> aucun effet, tjrs les meme performance

test sur du raid 10 -> aucun effet, tjrs les meme performance

Un certain nombre de tunning -> quelques effets mais tres aleatoire et pas forcement benefique

Activation du round robin sur ESXi a un IOPS => bénéfice sur le séquentiel

Activation des MTU 9000 => Tres peu d effet

J ai aussi teste le controleur paravirtuel sur esxi avec des bons résultats sur une VM mais qui ont evolué a la baisse ensuite

Du coup, j avoue ne plus trop savoir quoi chercher

Avez vous une suggestion ? Merci

Cela fait un certain temps que je me pose la question des performances sur le stockage suivant car il ne me semble pas avoir les performances en lien avec la configuration.

Super micro + expandeur sas 24 baie

LSI 9211-8i

CPU E3-1230 v3 @ 3.30GHz

32GB

12 x SSD 850 EVO 1To (11 * RaidZ2 + 1 spare)

2 cartes bi port 10Gbits sur 2 switch 10Gbits Dlink

MTU 9000

Ci-joint les performances moyenne que j obtiens entre freenas et ESXi en ISCSI en multipathing (cristaldiskmark avec 981.5 mbits)

Ci-joint les performances moyenne que j obtiens entre freenas et ESXI en ISCSI en multipathing en modifiant la talle des blocks (cristaldiskmark avec 6 copie d ecran)

Ci-joint les performances moyenne que j obtiens entre freenas et Windows en ISCSI SANS multipathing (cristaldiskmark avec 1145.9 mbits)

La config est standard

La LSI n'a pas de cache et est configuré avec le bios pour du stockage software

Le freenas est installé sur un raid1 par la carte interne raid et sur 2 SSD separés

Voici la liste des tests realisés

En local sur le freenas (en production)

dd if=/dev/zero of=test2.dat bs=4k count=2000000 => 817 555 495 bytes/sec

dd if=test2.dat of=test1.dat bs=4k count=2000000 => 110 048 055 bytes/sec (Problème de réglage on est plus a 400mbit en general)

dd if=test2.dat of=/dev/null bs=4k count=2000000 => 130 687 897 bytes/sec (idem probleme de reglage on est sense est plus haut)

La suppression des log -> aucun effet, tjrs les meme performance

test sur du raid 10 -> aucun effet, tjrs les meme performance

Un certain nombre de tunning -> quelques effets mais tres aleatoire et pas forcement benefique

Activation du round robin sur ESXi a un IOPS => bénéfice sur le séquentiel

Activation des MTU 9000 => Tres peu d effet

J ai aussi teste le controleur paravirtuel sur esxi avec des bons résultats sur une VM mais qui ont evolué a la baisse ensuite

Du coup, j avoue ne plus trop savoir quoi chercher

Avez vous une suggestion ? Merci