Hallo an alle.

Endlich habe ich mein neues System fertig und eingerichtet.

Habe ein paar Benchmarks ausgeführt, die ich heute mit dem Forum teilen möchte.

Ich fang am besten erst mal mit meinem neuen System an.

Der Server für den Hypervisor, in meinem Fall Esxi, ist ein Cisco UCSC-C220-M4S

CPU: 2* Intel(R) Xeon(R) 14C CPU E5-2690 v4 @ 2.60GHz

RAM: 128GB DDR4

Festplatten: 2* Samsung Evo 870 1TB

Netzwerkkarte für iSCSI: 1* Mellanox ConnectX3 Dual 40Gbit

Der Server der mit als Storage dient, ist ein Cisco UCSC-C240-M4

CPU: 1* Intel(R) Xeon(R) 6C CPU E5-2620 v3 @ 2.40GHz

RAM: 128GB DDR4

HBA: Cisco UCSC-SAS12GHBA 12G SAS 8-port Storage HBA IT-Mode Controller

Netzwerkkarte für iSCSI: 1* Mellanox ConnectX3 Dual 40Gbit

Festplatten:

4* 960GB Samsung PM9A3 Nvme - Gesteckt auf einer KALEA PCIe x16 M2 Controller Karte mit PEX 8747 Chip

5* 1,92TB Intel TLC/3D-S4520 SSD

Auf dem Storage-Server wurde TrueNAS Core installiert.

Ich habe zwei Pools angelegt, alle im Raidz1.

Einen Pool mit den Nvme's und einen mit den SSD's

Mirror habe ich bewusst nicht gewählt.

Beide Pools wurden mit ashift=12 und einer Recordsize=128K angelegt.

Auf beiden Pools wurde eine Platzreservierung von ca 20% festgelegt.

Dann habe ich ein zVol auf dem Nvme Pool und ein weiteres zVol auf dem SSD Pool erstellt.

Beide zVol's wurden mit einer Blocksize von 16K erstellt. Warum?

Wegen diesem Beitrag-> TRUENAS SCALE – ISCSI & VMWARE VSPHERE 7.X

Anschließend habe ich beide zVol's über iSCSI freigegeben. (Wie man iSCSI einrichtet ist heute nicht Thema meines Beitrages)

Zu beachten ist, das hier zwei Dinge angepasst werden.

1. Die Logische Blockgröße des iSCSI-Devices muss auf 512B gestellt und

2. Die Checkbox "Disable Physical Block Size Reporting" aktiviert werden.

Nach dem beide zVol's erstellt und eingerichtet wurden, habe ich noch zwei .img Files erstellt.

Eines im Nvme Pool und das andere im SSD Pool.

Erstellt habe ich die .img Files mit:

und anschließend auch mit iSCSI freigegeben. Gleiche Einstellungen wie be den zVol's.

Logische Block Size auf 512B und Checkbox aktiviert.

Die zVol's habe ich dann im Esxi einer Test-VM mit Windows Server 2019 zugeordnet.

Heißt: Ich habe keine Datastores in Esxi erstellt, sondern die Disk's direkt der VM zugeordnet. Das gleiche habe ich mit den iSCSI Freigaben der disk.img gemacht.

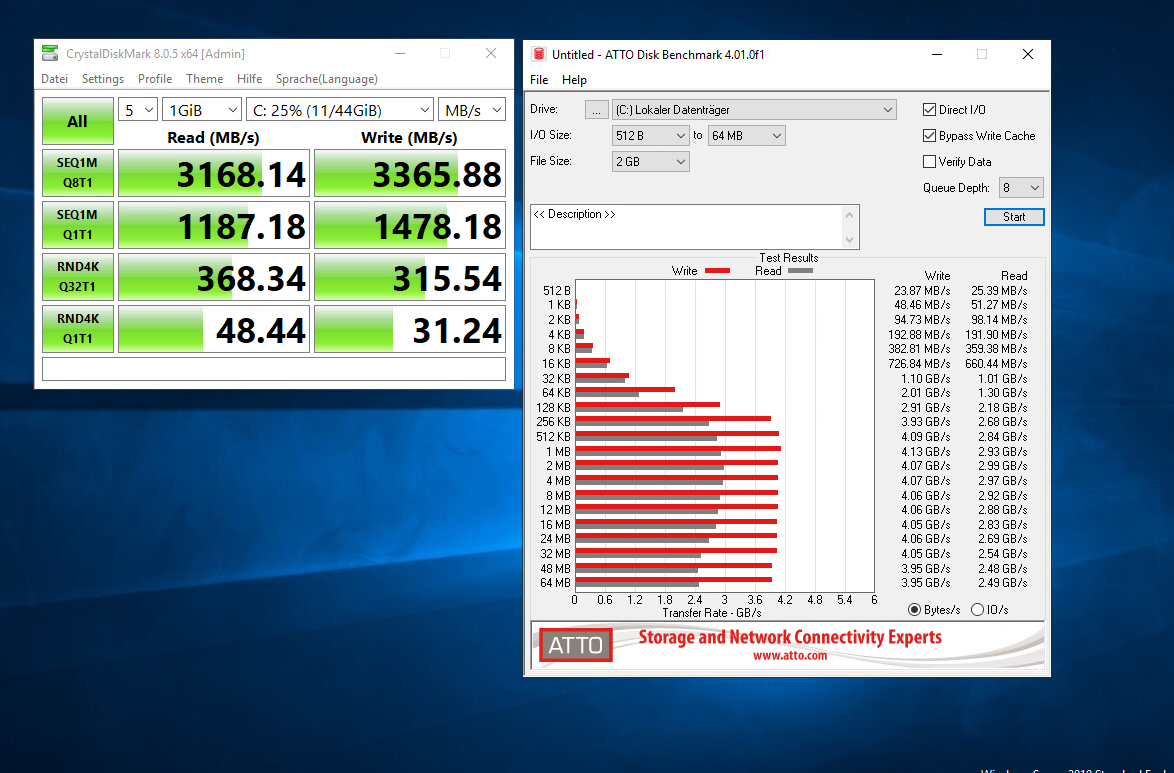

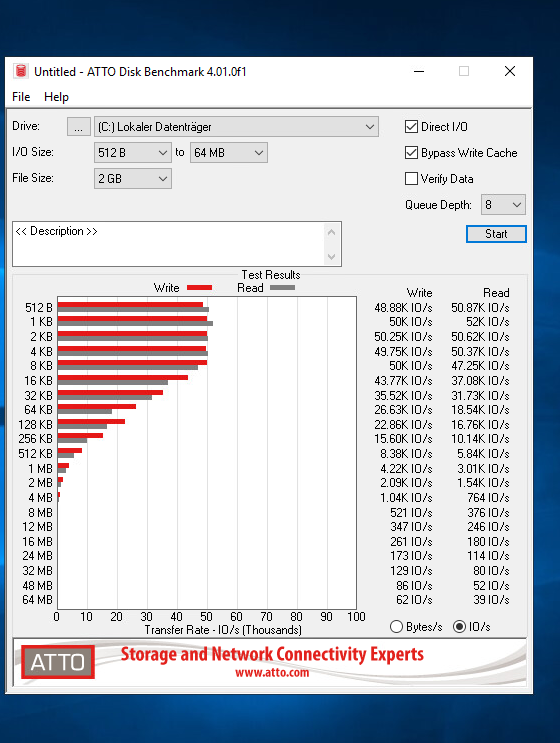

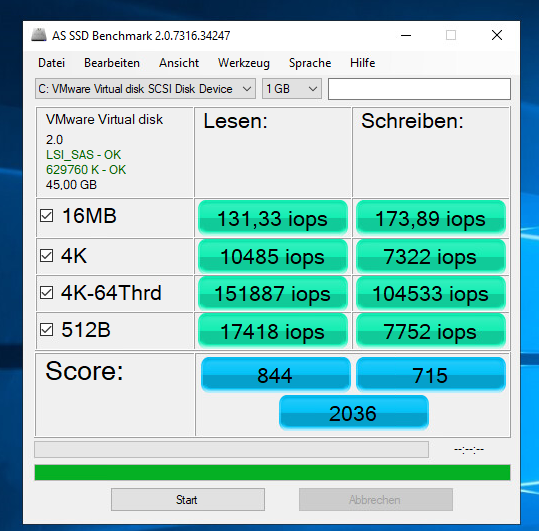

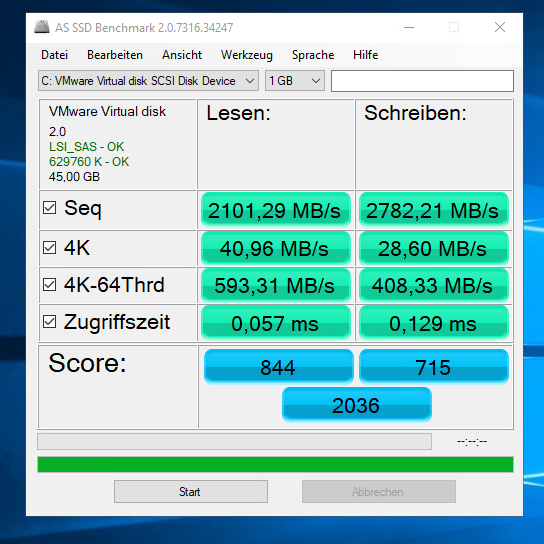

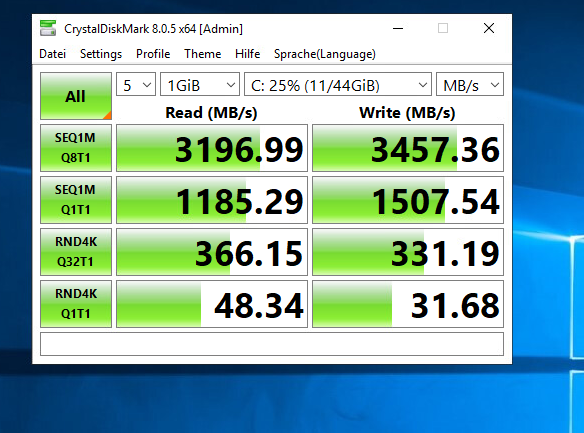

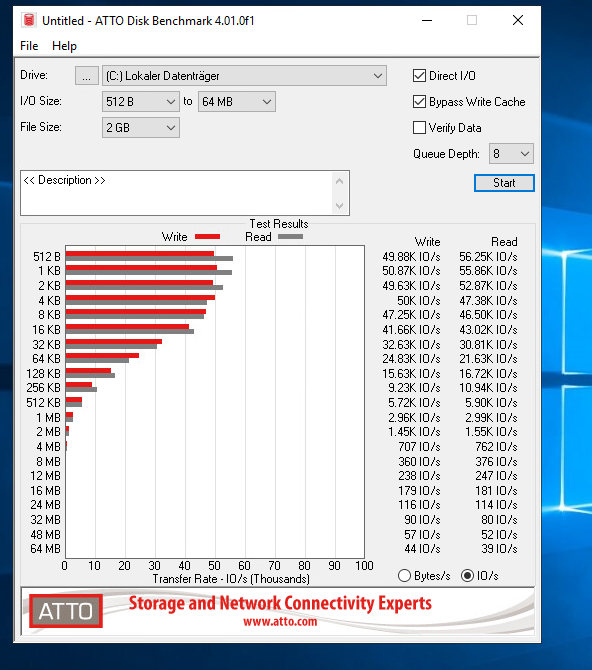

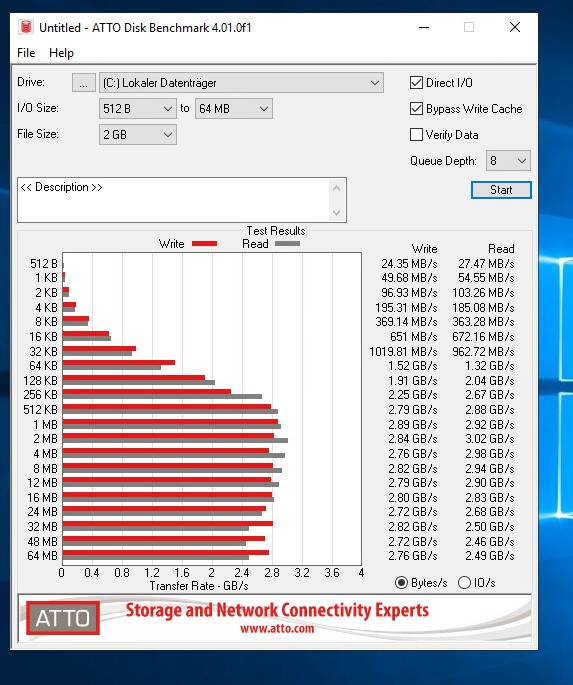

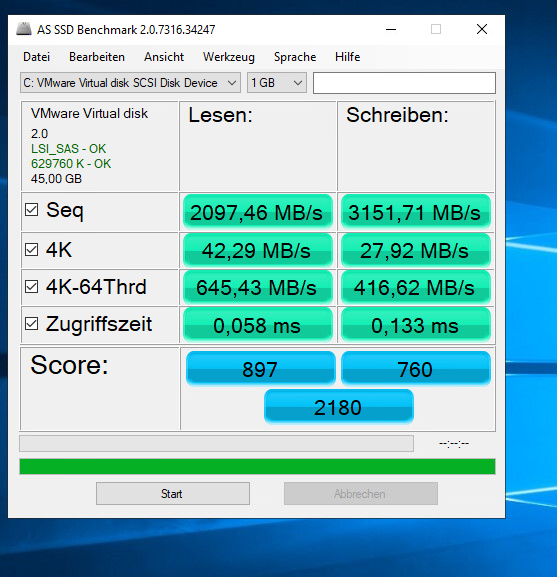

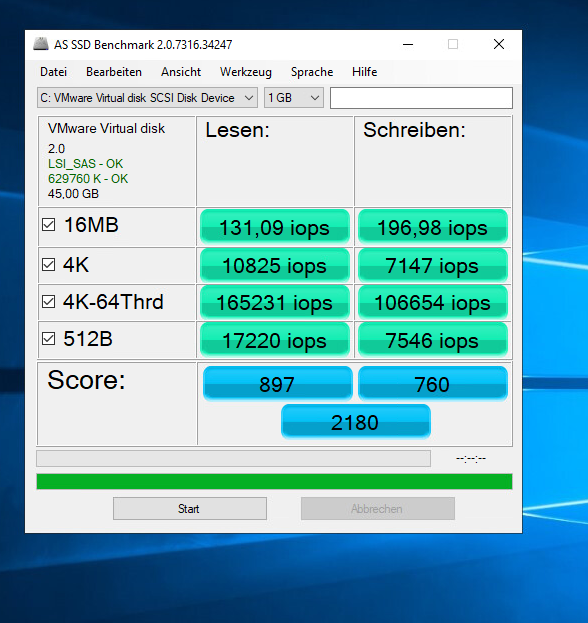

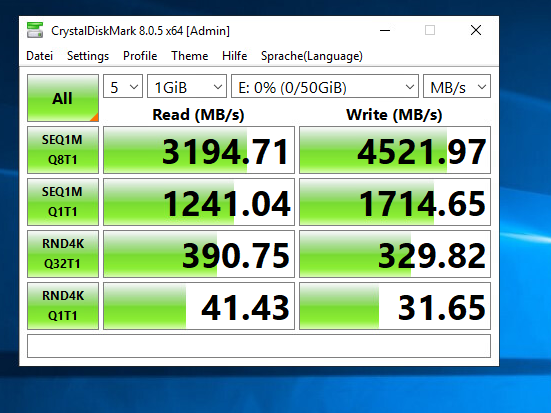

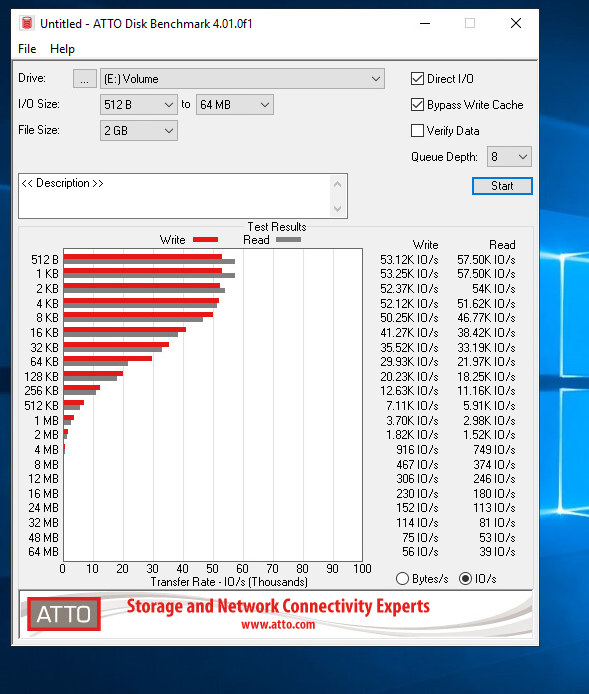

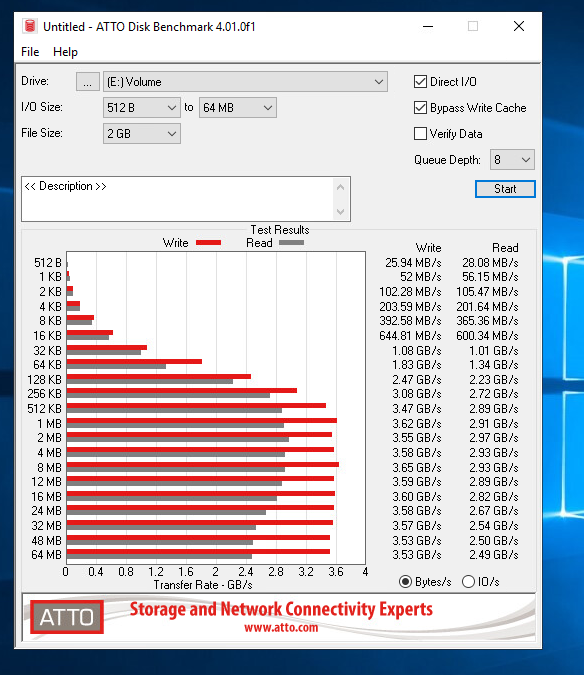

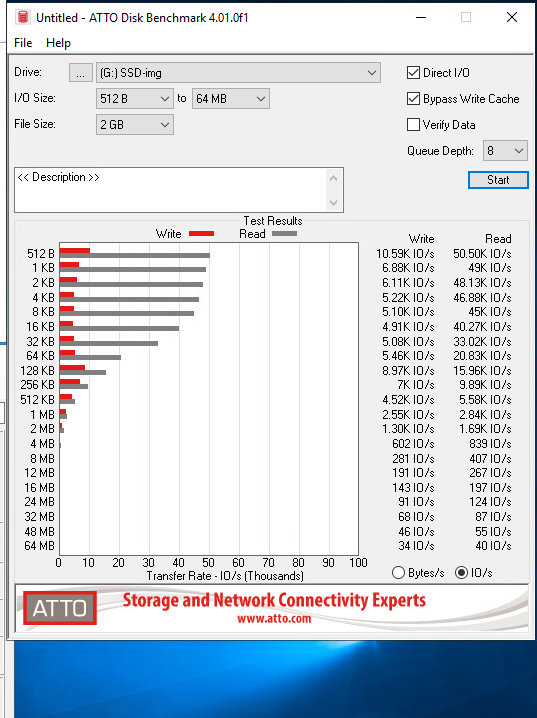

Nach dem Windows Server installiert war, habe ich CrystalDiskMark, ATTO Disk Benchmark und AS SSD Benchmark heruntergeladen und installiet.

Dann alle Festplatten eingebunden und mit NTFS formatiert, standard Blocksize.

Dann begang das Benchmarken.

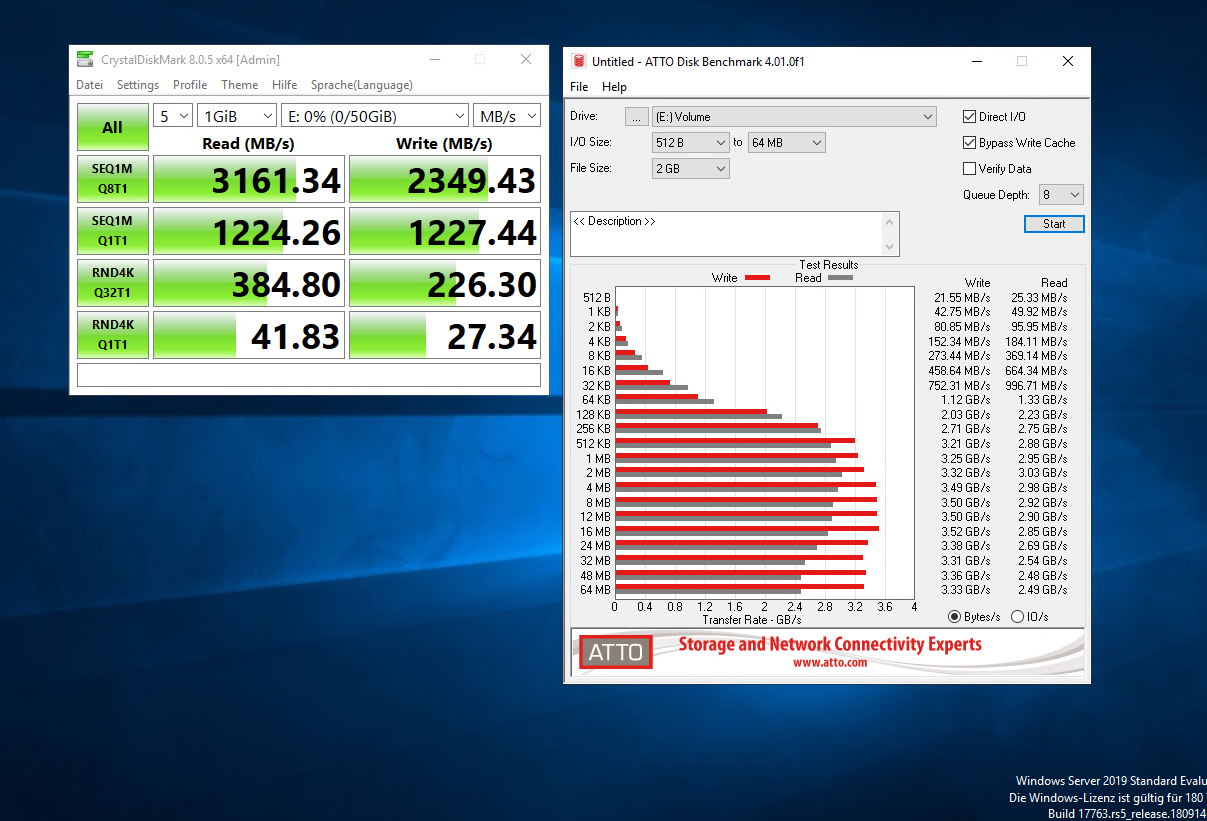

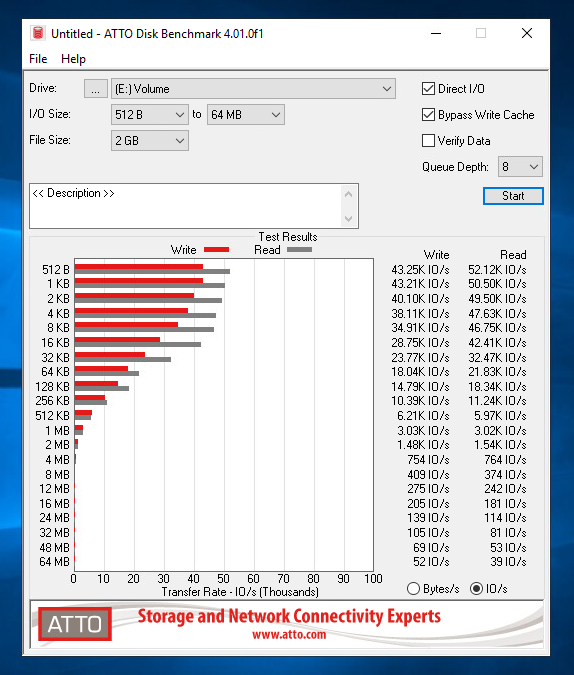

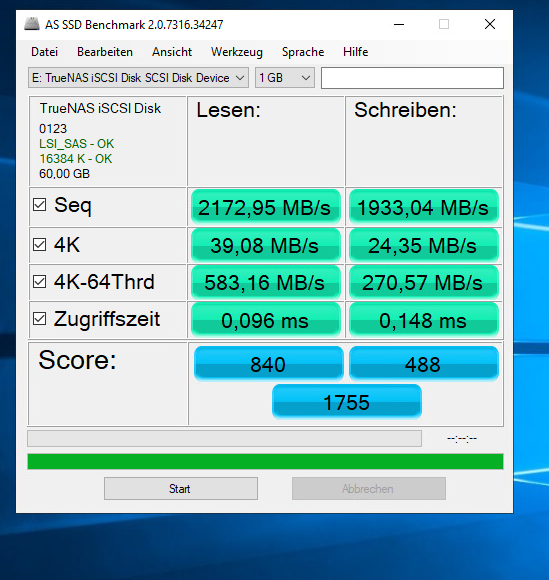

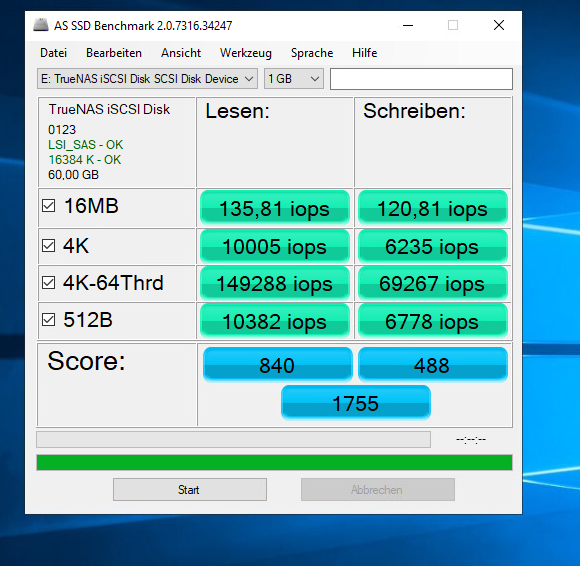

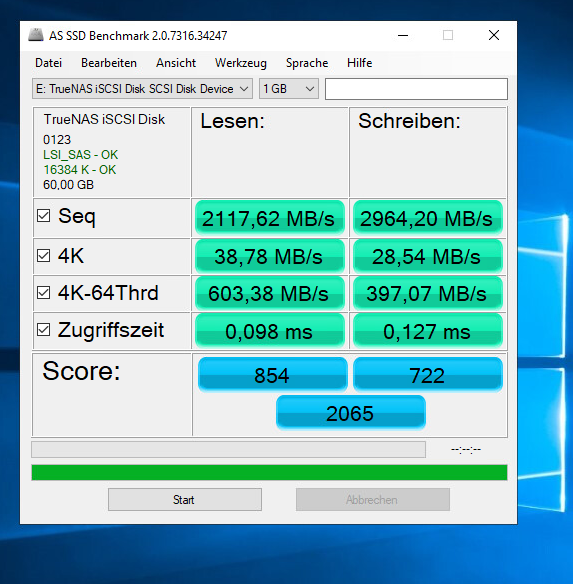

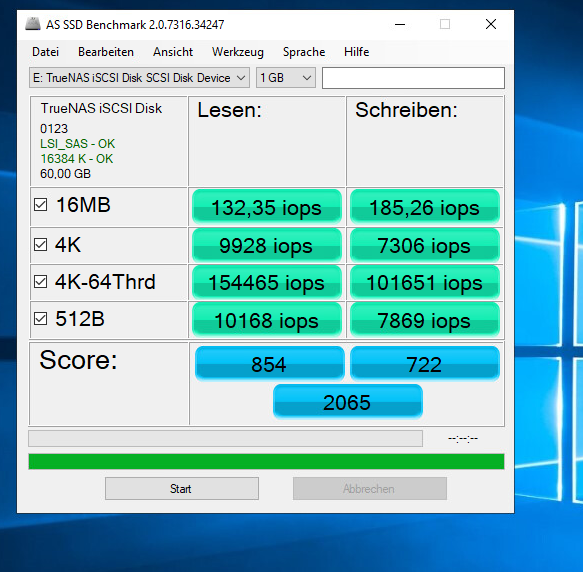

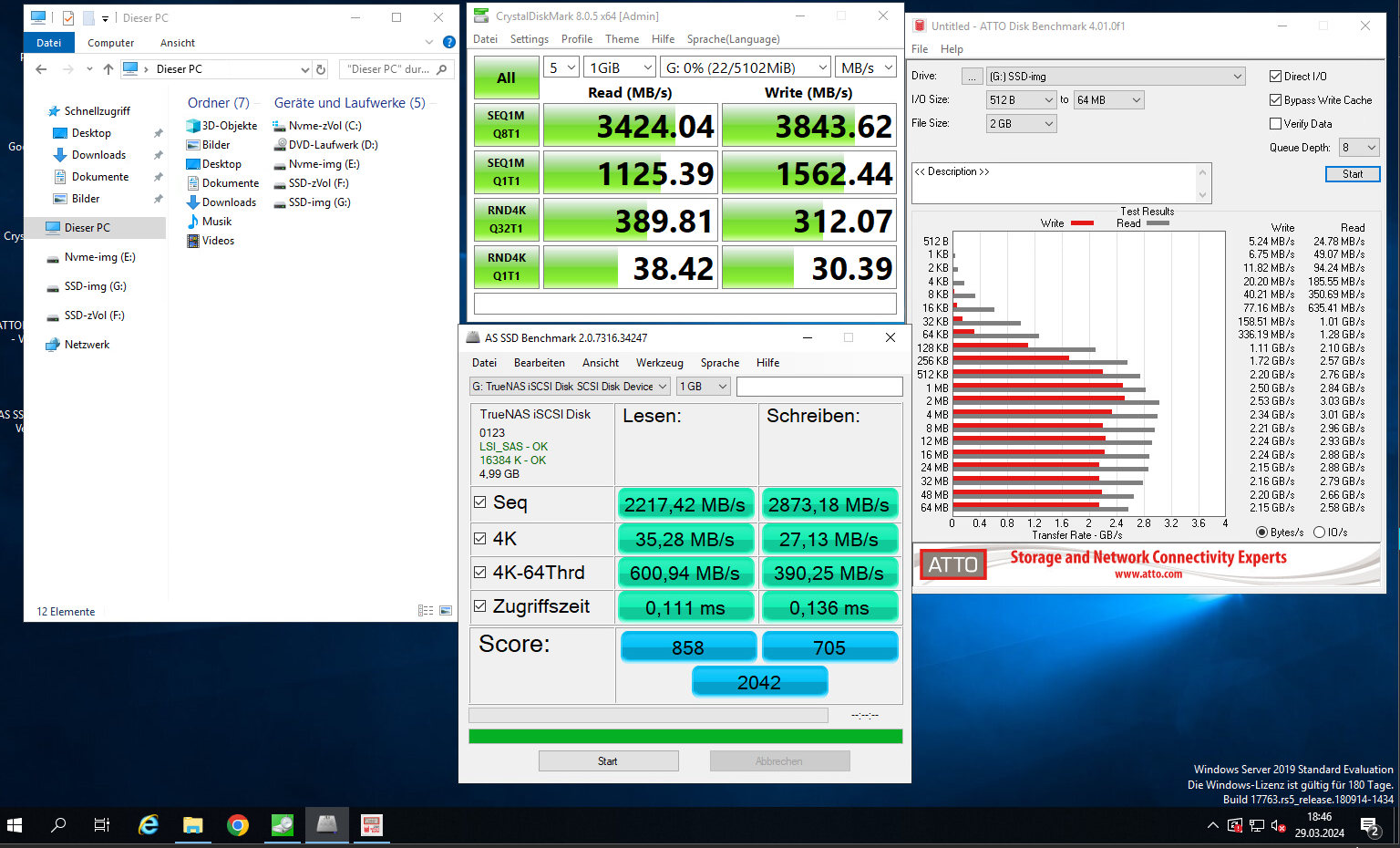

Hier sind die Ergebnisse:

Test 1: Nvme-zVol - Compression=ON Sync=ON

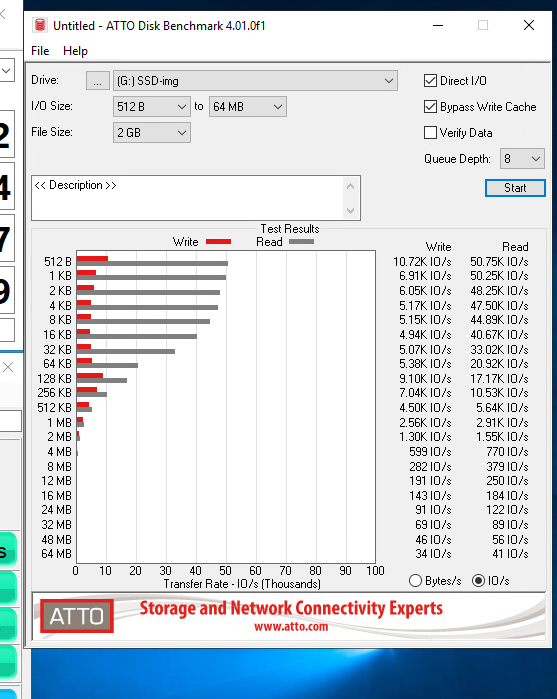

Test 2: Test 1: Nvme-img - Compression=ON Sync=ON

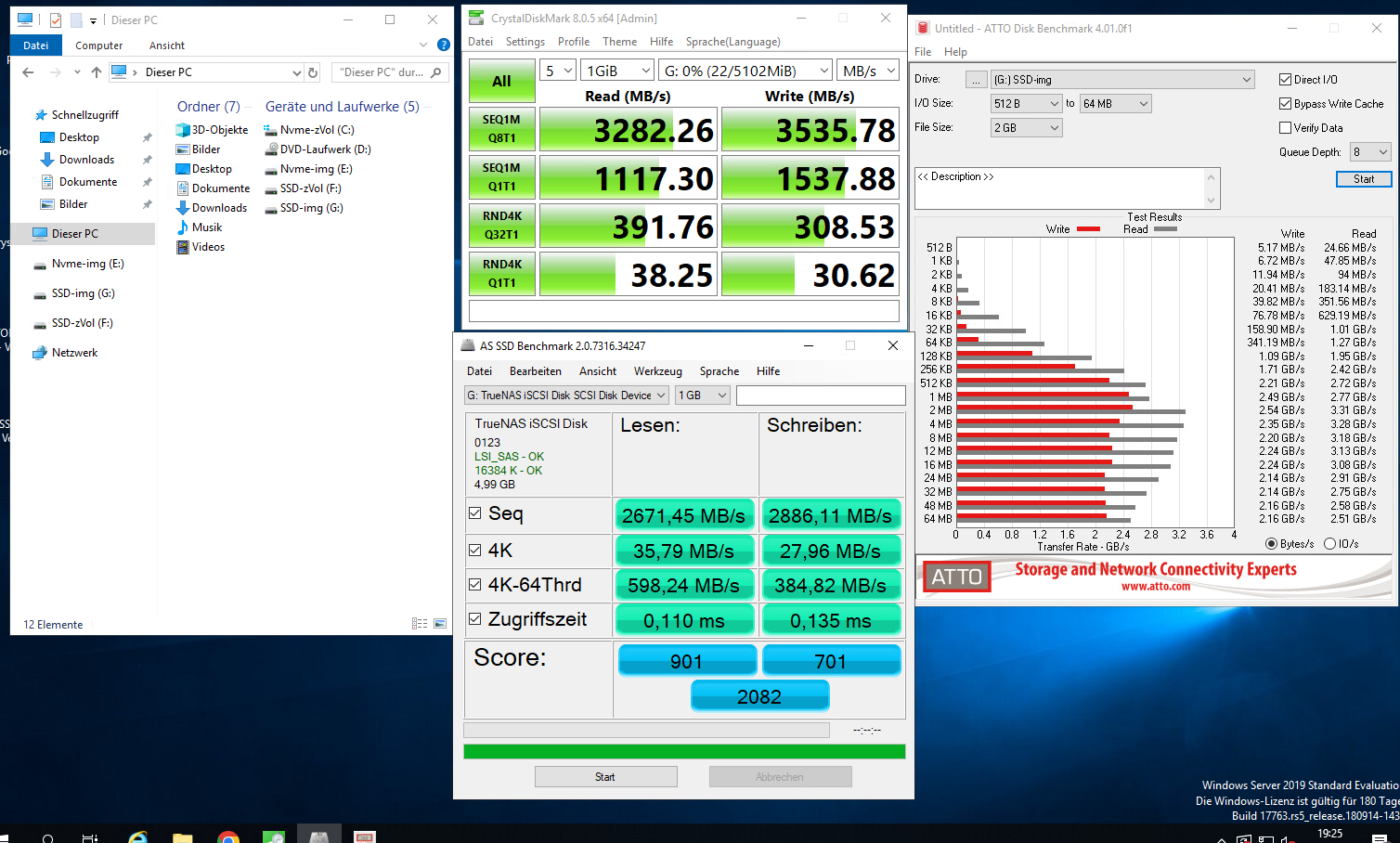

Test 3: Test 1: Nvme-zVol - Compression=OFF Sync=OFF

Test 4: Test 1: Nvme-img - Compression=OFF Sync=OFF

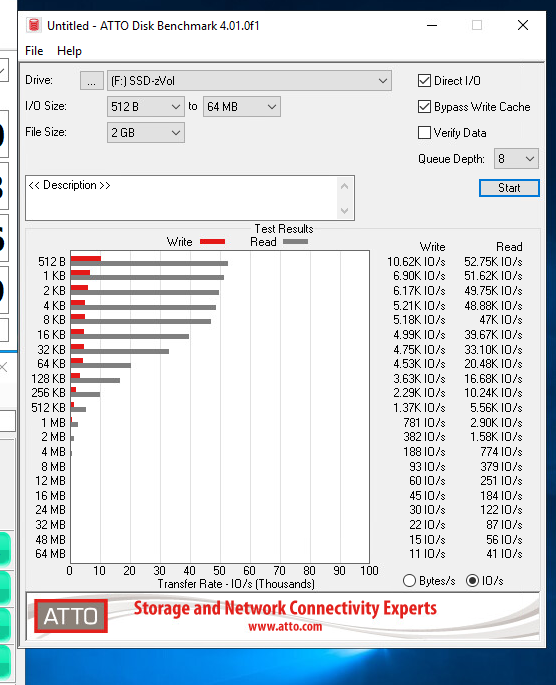

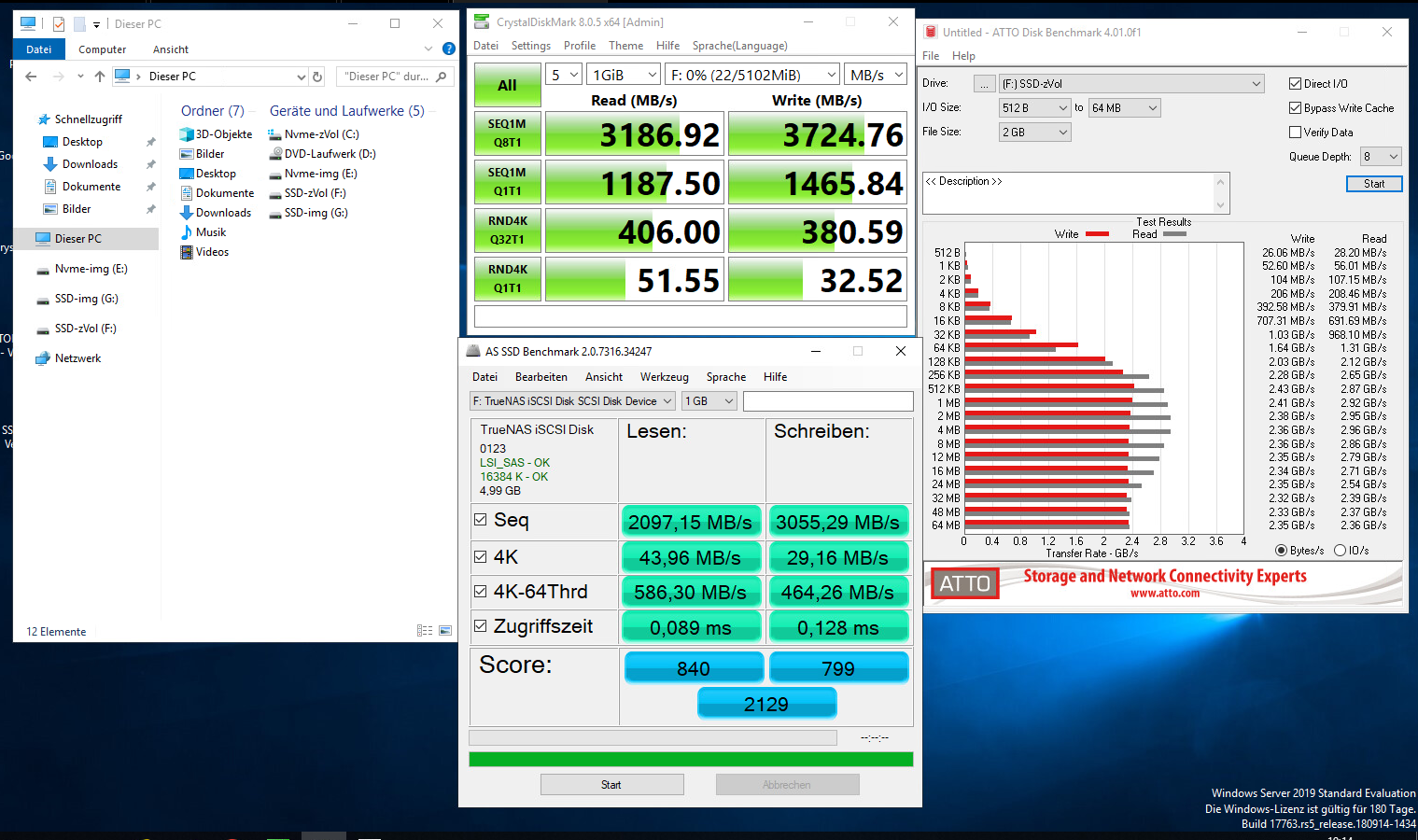

Test 5: Test 1: SSD-zVol - Compression=ON Sync=ON

Test 6: Test 1: SSD-img - Compression=ON Sync=ON

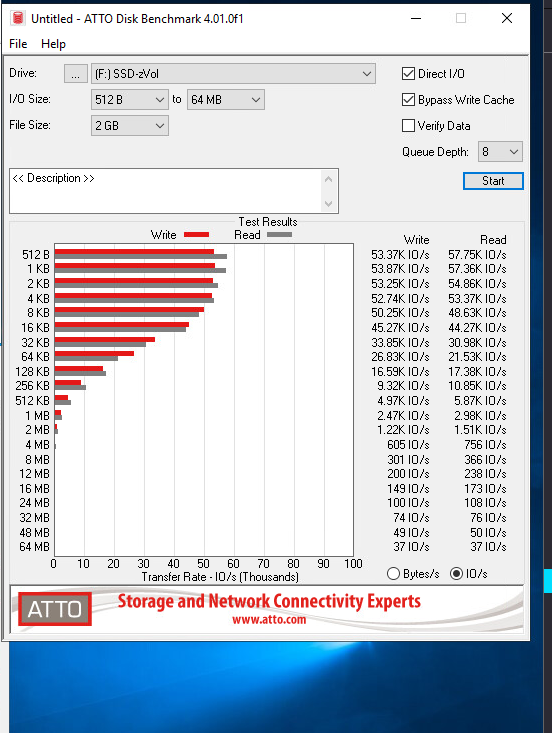

Test 7: Test 1: SSD-zVol - Compression=OFF Sync=OFF

Test 8: Test 1: SSD-img - Compression=OFF Sync=OFF

So, das war es erst mal. Ich hoffe alle Tests richtig ausgeführt zu haben.

Da es sich hier um mein Home-Lab handelt, glaube ich das sich das Ergebnis nicht verstecken muss.

Wenn ihr ein bestimmtes Ergebnis eines bestimmten Test sehen wollt, den ich ausführen soll, lasst es mic wissen.

Auffällig ist hier, das teilweise das IMG File +- 1GB's schneller beim schreiben zu sein scheint.

Auch das die SSD's fast genau so gut performen wie die Nvmes's.

Nun gut, lasst mal eure Meinung dazu da, würde mich freuen.

Endlich habe ich mein neues System fertig und eingerichtet.

Habe ein paar Benchmarks ausgeführt, die ich heute mit dem Forum teilen möchte.

Ich fang am besten erst mal mit meinem neuen System an.

Der Server für den Hypervisor, in meinem Fall Esxi, ist ein Cisco UCSC-C220-M4S

CPU: 2* Intel(R) Xeon(R) 14C CPU E5-2690 v4 @ 2.60GHz

RAM: 128GB DDR4

Festplatten: 2* Samsung Evo 870 1TB

Netzwerkkarte für iSCSI: 1* Mellanox ConnectX3 Dual 40Gbit

Der Server der mit als Storage dient, ist ein Cisco UCSC-C240-M4

CPU: 1* Intel(R) Xeon(R) 6C CPU E5-2620 v3 @ 2.40GHz

RAM: 128GB DDR4

HBA: Cisco UCSC-SAS12GHBA 12G SAS 8-port Storage HBA IT-Mode Controller

Netzwerkkarte für iSCSI: 1* Mellanox ConnectX3 Dual 40Gbit

Festplatten:

4* 960GB Samsung PM9A3 Nvme - Gesteckt auf einer KALEA PCIe x16 M2 Controller Karte mit PEX 8747 Chip

5* 1,92TB Intel TLC/3D-S4520 SSD

Auf dem Storage-Server wurde TrueNAS Core installiert.

Ich habe zwei Pools angelegt, alle im Raidz1.

Einen Pool mit den Nvme's und einen mit den SSD's

Mirror habe ich bewusst nicht gewählt.

Beide Pools wurden mit ashift=12 und einer Recordsize=128K angelegt.

Auf beiden Pools wurde eine Platzreservierung von ca 20% festgelegt.

Dann habe ich ein zVol auf dem Nvme Pool und ein weiteres zVol auf dem SSD Pool erstellt.

Beide zVol's wurden mit einer Blocksize von 16K erstellt. Warum?

Wegen diesem Beitrag-> TRUENAS SCALE – ISCSI & VMWARE VSPHERE 7.X

Anschließend habe ich beide zVol's über iSCSI freigegeben. (Wie man iSCSI einrichtet ist heute nicht Thema meines Beitrages)

Zu beachten ist, das hier zwei Dinge angepasst werden.

1. Die Logische Blockgröße des iSCSI-Devices muss auf 512B gestellt und

2. Die Checkbox "Disable Physical Block Size Reporting" aktiviert werden.

Nach dem beide zVol's erstellt und eingerichtet wurden, habe ich noch zwei .img Files erstellt.

Eines im Nvme Pool und das andere im SSD Pool.

Erstellt habe ich die .img Files mit:

Code:

truncate -s 5G /mnt/Nvme-Pool-01/lun2/disk.img truncate -s 5G /mnt/SSD-Pool-01/lun2/disk.img

und anschließend auch mit iSCSI freigegeben. Gleiche Einstellungen wie be den zVol's.

Logische Block Size auf 512B und Checkbox aktiviert.

Die zVol's habe ich dann im Esxi einer Test-VM mit Windows Server 2019 zugeordnet.

Heißt: Ich habe keine Datastores in Esxi erstellt, sondern die Disk's direkt der VM zugeordnet. Das gleiche habe ich mit den iSCSI Freigaben der disk.img gemacht.

Nach dem Windows Server installiert war, habe ich CrystalDiskMark, ATTO Disk Benchmark und AS SSD Benchmark heruntergeladen und installiet.

Dann alle Festplatten eingebunden und mit NTFS formatiert, standard Blocksize.

Dann begang das Benchmarken.

Hier sind die Ergebnisse:

Test 1: Nvme-zVol - Compression=ON Sync=ON

Test 2: Test 1: Nvme-img - Compression=ON Sync=ON

Test 3: Test 1: Nvme-zVol - Compression=OFF Sync=OFF

Test 4: Test 1: Nvme-img - Compression=OFF Sync=OFF

Test 5: Test 1: SSD-zVol - Compression=ON Sync=ON

Test 6: Test 1: SSD-img - Compression=ON Sync=ON

Test 7: Test 1: SSD-zVol - Compression=OFF Sync=OFF

Test 8: Test 1: SSD-img - Compression=OFF Sync=OFF

So, das war es erst mal. Ich hoffe alle Tests richtig ausgeführt zu haben.

Da es sich hier um mein Home-Lab handelt, glaube ich das sich das Ergebnis nicht verstecken muss.

Wenn ihr ein bestimmtes Ergebnis eines bestimmten Test sehen wollt, den ich ausführen soll, lasst es mic wissen.

Auffällig ist hier, das teilweise das IMG File +- 1GB's schneller beim schreiben zu sein scheint.

Auch das die SSD's fast genau so gut performen wie die Nvmes's.

Nun gut, lasst mal eure Meinung dazu da, würde mich freuen.